Objectivos de Aprendizagem

- Eliminar os princípios do condicionamento operante.

- Explicar como a aprendizagem pode ser moldada através da utilização de horários de reforço e reforços secundários.

No condicionamento clássico o organismo aprende a associar novos estímulos com respostas biológicas naturais, tais como salivação ou medo. O organismo não aprende algo novo, mas começa antes a executar um comportamento existente na presença de um novo sinal. O condicionamento operante, por outro lado, é uma aprendizagem que ocorre com base nas consequências do comportamento e pode envolver a aprendizagem de novas acções. O condicionamento operante ocorre quando um cão rola sob comando porque foi elogiado por o ter feito no passado, quando um rufia de sala de aula ameaça os seus colegas de turma porque o facto de o fazer lhe permite fazer o seu caminho, e quando uma criança recebe boas notas porque os seus pais ameaçam castigá-la se não o fizer. No condicionamento operante o organismo aprende com as consequências das suas próprias acções.

Como o Reforço e o Comportamento de Punição Influenciam o Comportamento: A Investigação de Thorndike e Skinner

Psychologist Edward L. Thorndike (1874-1949) foi o primeiro cientista a estudar sistematicamente o condicionamento operante. Na sua pesquisa Thorndike (1898) observou gatos que tinham sido colocados numa “caixa de puzzle” da qual tentavam escapar (“Video Clip: Thorndike’s Puzzle Box”). No início, os gatos arranharam, morderam e esborracharam de forma aleatória, sem qualquer ideia de como sair. Mas eventualmente, e acidentalmente, eles pressionaram a alavanca que abriu a porta e saíram para o seu prémio, um pedaço de peixe. Da próxima vez que o gato foi constrangido dentro da caixa, tentou menos das respostas ineficazes antes de realizar a fuga bem sucedida, e após várias tentativas o gato aprendeu a fazer quase imediatamente a resposta correcta.

Observar estas mudanças no comportamento dos gatos levou Thorndike a desenvolver a sua lei de efeito, o princípio de que as respostas que criam um resultado tipicamente agradável numa situação particular são mais susceptíveis de ocorrer novamente numa situação semelhante, enquanto que as respostas que produzem um resultado tipicamente desagradável são menos susceptíveis de ocorrer novamente na situação (Thorndike, 1911). A essência da lei do efeito é que as respostas bem sucedidas, por serem agradáveis, são “carimbadas” pela experiência e, portanto, ocorrem com mais frequência. As respostas mal sucedidas, que produzem experiências desagradáveis, são “carimbadas” e subsequentemente ocorrem com menos frequência.

Quando Thorndike colocou os seus gatos numa caixa de puzzle, descobriu que eles aprenderam a envolver-se no importante comportamento de fuga mais rapidamente após cada julgamento. Thorndike descreveu a aprendizagem que se segue ao reforço em termos da lei do efeito.

Watch: “Thorndike’s Puzzle Box” : http://www.youtube.com/watch?v=BDujDOLre-8

Watch: “Thorndike’s Puzzle Box” : http://www.youtube.com/watch?v=BDujDOLre-8

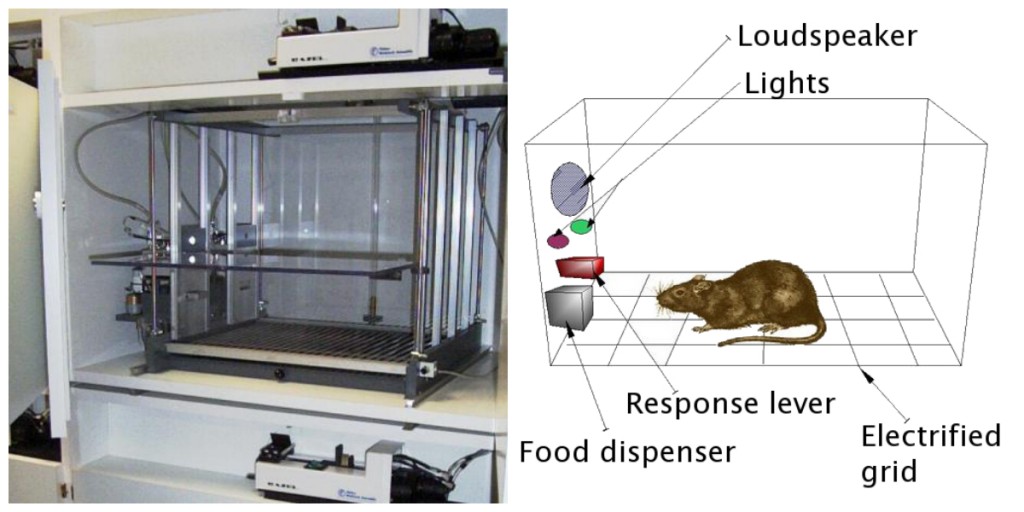

O influente psicólogo comportamental B. F. Skinner (1904-1990) expandiu as ideias de Thorndike para desenvolver um conjunto mais completo de princípios para explicar o condicionamento operante. Skinner criou ambientes especialmente concebidos conhecidos como câmaras operantes (geralmente chamados de caixas Skinner) para estudar sistematicamente a aprendizagem. Uma caixa Skinner (câmara operante) é uma estrutura suficientemente grande para caber num roedor ou pássaro e que contém uma barra ou chave que o organismo pode pressionar ou bicar para libertar comida ou água. Contém também um dispositivo para registar as respostas do animal (Figura 8.5).

A mais básica das experiências de Skinner foi bastante semelhante à investigação de Thorndike com gatos. Um rato colocado na câmara reagiu como seria de esperar, a correr sobre a caixa e a farejar e a arranhar no chão e nas paredes. Eventualmente, o rato avançou sobre uma alavanca, que pressionou para libertar pellets de comida. Da vez seguinte, o rato demorou um pouco menos de tempo a pressionar a alavanca, e em testes sucessivos, o tempo que demorou a pressionar a alavanca tornou-se cada vez mais curto. Logo o rato pressionava a alavanca o mais rápido que podia comer os alimentos que apareciam. Como previsto pela lei do efeito, o rato tinha aprendido a repetir a acção que provocou o alimento e a cessar as acções que não o fizeram.

Skinner estudou, em pormenor, como os animais mudaram o seu comportamento através de reforço e punição, e desenvolveu termos que explicavam os processos de aprendizagem operante (Tabela 8.1, “Como o Reforço Positivo e Negativo e o Comportamento de Punição Influenciam”). Skinner utilizou o termo reforço para se referir a qualquer evento que reforce ou aumente a probabilidade de um comportamento, e o termo punidor para se referir a qualquer evento que enfraqueça ou diminua a probabilidade de um comportamento. E utilizou os termos positivo e negativo para se referir se um reforço foi apresentado ou removido, respectivamente. Assim, o reforço positivo reforça uma resposta ao apresentar algo agradável após a resposta, e o reforço negativo reforça uma resposta ao reduzir ou remover algo desagradável. Por exemplo, elogiar uma criança por completar os seus trabalhos de casa representa um reforço positivo, enquanto que tomar Aspirina para reduzir a dor de cabeça representa um reforço negativo. Em ambos os casos, o reforço torna mais provável que o comportamento ocorra novamente no futuro.

| Termo de condicionamento permanente | Descrição | Outcome | Exemplo |

|---|---|---|---|

| Reforço positivo | Add ou aumentar um estímulo agradável | Comportamento é reforçado | Dar um prémio ao aluno depois de ele ou ela receber um A num teste |

| Reduzir ou remover um estímulo desagradável | Comportamento é reforçado | Take analgésicos que eliminam a dor aumenta a probabilidade de voltar a tomar analgésicos | |

| Punição positiva | Apresentar ou adicionar um estímulo desagradável | Comportamento enfraquecido | |

| Punição negativa | Reduzir ou remover um estímulo agradável | Comportamento é enfraquecido | Taking afastar o computador de um adolescente depois de ele ou ela perder o recolher obrigatório |

Reinforcement, seja positivo ou negativo, funciona aumentando a probabilidade de um comportamento. A punição, por outro lado, refere-se a qualquer acontecimento que enfraqueça ou reduza a probabilidade de um comportamento. A punição positiva enfraquece uma resposta ao apresentar algo desagradável após a resposta, enquanto que a punição negativa enfraquece uma resposta ao reduzir ou remover algo agradável. Uma criança que é castigada depois de lutar com um irmão (castigo positivo) ou que perde a oportunidade de ir para o intervalo depois de obter uma má nota (castigo negativo) tem menos probabilidades de repetir estes comportamentos.

Embora a distinção entre reforço (que aumenta o comportamento) e castigo (que o diminui) seja geralmente clara, em alguns casos é difícil determinar se um reforço é positivo ou negativo. Num dia quente, uma brisa fresca pode ser vista como um reforço positivo (porque traz ar frio) ou um reforço negativo (porque remove o ar quente). Em outros casos, o reforço pode ser tanto positivo como negativo. Pode-se fumar um cigarro tanto porque traz prazer (reforço positivo) como porque elimina o desejo de nicotina (reforço negativo).

É também importante notar que o reforço e a punição não são simplesmente opostos. A utilização do reforço positivo na mudança de comportamento é quase sempre mais eficaz do que a utilização do castigo. Isto porque o reforço positivo faz a pessoa ou o animal sentir-se melhor, ajudando a criar uma relação positiva com a pessoa que fornece o reforço. Os tipos de reforço positivo que são eficazes na vida quotidiana incluem elogios ou aprovação verbal, a atribuição de estatuto ou prestígio, e pagamento financeiro directo. A punição, por outro lado, é mais susceptível de criar apenas mudanças temporárias de comportamento, porque se baseia na coerção e tipicamente cria uma relação negativa e contraditória com a pessoa que fornece o reforço. Quando a pessoa que dá o castigo deixa a situação, o comportamento indesejado é susceptível de regressar.

Criar Comportamentos Complexos através do Condicionamento Operante

Talvez se lembre de ver um filme ou de estar num espectáculo em que um animal – talvez um cão, um cavalo, ou um golfinho – fez algumas coisas espantosas. O treinador deu um comando e o golfinho nadou até ao fundo da piscina, pegou num anel no seu nariz, saltou para fora da água através de um aro no ar, mergulhou novamente para o fundo da piscina, pegou noutro anel, e depois levou ambos os anéis para o treinador à beira da piscina. O animal foi treinado para fazer o truque, e os princípios do condicionamento operante foram utilizados para o treinar. Mas estes comportamentos complexos estão longe das simples relações estímulo-resposta que temos considerado até agora. Como pode o reforço ser utilizado para criar comportamentos complexos como estes?

Uma forma de expandir a utilização da aprendizagem operante é modificar o horário em que o reforço é aplicado. A este ponto apenas discutimos um programa de reforço contínuo, no qual a resposta desejada é reforçada cada vez que ocorre; sempre que o cão rola, por exemplo, recebe um biscoito. O reforço contínuo resulta numa aprendizagem relativamente rápida, mas também numa rápida extinção do comportamento desejado, uma vez que o reforço desaparece. O problema é que, porque o organismo está habituado a receber o reforço após cada comportamento, o respondedor pode desistir rapidamente quando este não aparece.

Os reforços mais reais não são contínuos; ocorrem num horário de reforço parcial (ou intermitente) – um horário em que as respostas são por vezes reforçadas e outras vezes não. Em comparação com os reforços contínuos, os programas de reforço parcial levam a uma aprendizagem inicial mais lenta, mas também levam a uma maior resistência à extinção. Como o reforço não aparece após cada comportamento, demora mais tempo para que o aprendiz determine que a recompensa já não vem, e assim a extinção é mais lenta. Os quatro tipos de programas de reforço parcial estão resumidos na Tabela 8.2, “Horários de Reforço”

| Reinforcement schedule | Explanation | Real-exemplo mundial |

|---|---|---|

| Fixed-ratio | O comportamento é reforçado após um número específico de respostas. | Trabalhadores de fábrica que são pagos de acordo com o número de produtos que produzem |

| Rácio variável | Comportamento é reforçado após um número médio, mas imprevisível, de respostas. | Payoffs das slot machines e outros jogos de azar |

| Intervalo fixo | Comportamento é reforçado para a primeira resposta após um período de tempo específico ter passado. | Pessoas que ganham um salário mensal |

| Intervalo variável | Comportamento é reforçado para a primeira resposta após um período médio, mas imprevisível, de tempo passado. | Pessoa que verifica as mensagens de correio electrónico |

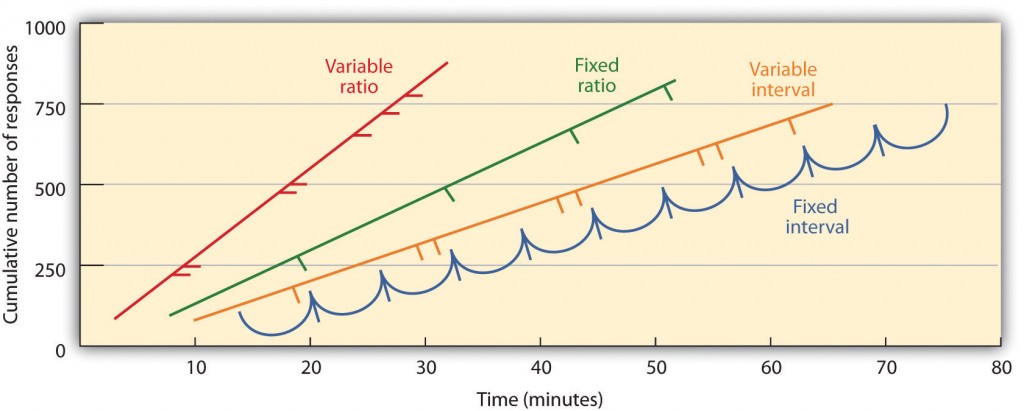

As programações parciais de reforço são determinadas pelo facto de o reforço ser apresentado com base no tempo que decorre entre o reforço (intervalo) ou com base no número de respostas em que o organismo se envolve (relação), e se o reforço ocorre num horário regular (fixo) ou imprevisível (variável). Num horário de intervalo fixo, o reforço ocorre para a primeira resposta feita após um período de tempo específico. Por exemplo, num horário de intervalo fixo de um minuto, o animal recebe um reforço a cada minuto, assumindo que se envolve no comportamento pelo menos uma vez durante o minuto. Como se pode ver na Figura 8.6, “Exemplos de Padrões de Resposta por Animais Treinados sob Diferentes Horários de Reforço Parcial”, os animais sob horários de intervalo fixo tendem a abrandar a sua resposta imediatamente após o reforço, mas depois aumentam novamente o comportamento à medida que o tempo do próximo reforço se aproxima. (A maioria dos estudantes estuda para exames da mesma forma.) Num horário de intervalo variável, os reforços aparecem num horário de intervalo, mas o horário varia em torno do intervalo médio, tornando imprevisível o aspecto real do reforço. Um exemplo pode ser a verificação do seu e-mail: é reforçado ao receber mensagens que chegam, em média, digamos, de 30 em 30 minutos, mas o reforço ocorre apenas em momentos aleatórios. Os intervalos de reforço tendem a produzir taxas lentas e estáveis de resposta.

Num horário de rácio fixo, um comportamento é reforçado após um número específico de respostas. Por exemplo, o comportamento de um rato pode ser reforçado depois de ter premido uma tecla 20 vezes, ou um vendedor pode receber um bónus depois de ter vendido 10 produtos. Como se pode ver na Figura 8.6, “Exemplos de Padrões de Resposta por Animais Treinados sob Diferentes Horários de Reforço Parcial”, uma vez que o organismo tenha aprendido a agir de acordo com o horário de relação fixa, só fará uma breve pausa quando o reforço ocorrer antes de regressar a um elevado nível de capacidade de resposta. Um calendário de proporção variável fornece reforços após um número específico mas médio de respostas. Ganhar dinheiro a partir de máquinas de slots ou num bilhete de lotaria é um exemplo de reforço que ocorre num calendário de relação variável. Por exemplo, uma slot machine (ver Figura 8.7, “Slot Machine”) pode ser programada para fornecer um ganho a cada 20 vezes que o utilizador puxa a pega, em média. A relação de horários tende a produzir altas taxas de resposta porque o reforço aumenta à medida que o número de respostas aumenta.

comportamentos complexos são também criados através da moldagem, o processo de orientar o comportamento de um organismo para o resultado desejado através da utilização de sucessivas aproximações a um comportamento final desejado. O Skinner fez um uso extensivo deste procedimento nas suas caixas. Por exemplo, ele podia treinar um rato a pressionar uma barra duas vezes para receber alimentos, fornecendo primeiro alimentos quando o animal se aproximava da barra. Quando esse comportamento tivesse sido aprendido, Skinner começaria a fornecer alimentos apenas quando o rato tocasse na barra. A formação posterior limitava o reforço a apenas quando o rato pressionava a barra, a quando pressionava a barra e lhe tocava uma segunda vez, e finalmente a apenas quando pressionava a barra duas vezes. Embora possa demorar muito tempo, desta forma o condicionamento operante pode criar cadeias de comportamentos que são reforçados apenas quando são completados.

Reinforçando os animais se estes discriminarem correctamente entre estímulos semelhantes permite aos cientistas testar a capacidade de aprendizagem dos animais, e as discriminações que eles podem fazer são por vezes notáveis. Os pombos foram treinados para distinguir entre as imagens de Charlie Brown e os outros personagens de Peanuts (Cerella, 1980), e entre diferentes estilos de música e arte (Porter & Neuringer, 1984; Watanabe, Sakamoto & Wakita, 1995).

Comportamentos também podem ser treinados através da utilização de reforços secundários. Enquanto que um reforço primário inclui estímulos que são naturalmente preferidos ou apreciados pelo organismo, tais como comida, água, e alívio da dor, um reforço secundário (por vezes chamado reforço condicionado) é um evento neutro que se tornou associado a um reforço primário através do condicionamento clássico. Um exemplo de um reforço secundário seria o apito dado por um treinador de animais, que tem sido associado ao longo do tempo com o reforço primário, alimento. Um exemplo de um reforço secundário diário é o dinheiro. Gostamos de ter dinheiro, não tanto para o estímulo em si, mas sim para os reforços primários (as coisas que o dinheiro pode comprar) com os quais está associado.

Key Takeaways

- Edward Thorndike desenvolveu a lei do efeito: o princípio de que as respostas que criam um resultado tipicamente agradável numa determinada situação são mais susceptíveis de ocorrer novamente numa situação semelhante, enquanto que as respostas que produzem um resultado tipicamente desagradável são menos susceptíveis de ocorrer novamente na situação.

- B. F. Skinner expandiu as ideias de Thorndike para desenvolver um conjunto de princípios para explicar o condicionamento operante.

- reforço positivo fortalece uma resposta apresentando algo que é tipicamente agradável após a resposta, enquanto o reforço negativo fortalece uma resposta reduzindo ou removendo algo que é tipicamente desagradável.

- Punição positiva enfraquece uma resposta ao apresentar algo tipicamente desagradável após a resposta, enquanto que a punição negativa enfraquece uma resposta ao reduzir ou remover algo que é tipicamente agradável.

- Punição positiva pode ser parcial ou contínua. Os horários parciais de reforço são determinados pelo facto de o reforço ser apresentado com base no tempo que decorre entre reforços (intervalo) ou com base no número de respostas em que o organismo se envolve (rácio), e pelo facto de o reforço ocorrer num horário regular (fixo) ou imprevisível (variável).

- Comportamentos complexos podem ser criados através da moldagem, o processo de orientar o comportamento de um organismo para o resultado desejado através da utilização de sucessivas aproximações a um comportamento final desejado.

Exercícios e Pensamento Crítico

- Dê um exemplo da vida diária de cada um dos seguintes: reforço positivo, reforço negativo, castigo positivo, castigo negativo.

- Considere as técnicas de reforço que pode utilizar para treinar um cão a apanhar e recuperar um Frisbee que lhe atira.

- Veja os dois vídeos seguintes de programas de televisão actuais. Pode determinar quais os procedimentos de aprendizagem que estão a ser demonstrados?

- The Office: http://www.break.com/usercontent/2009/11/the-office-altoid- experiment-1499823

- The Big Bang Theory : http://www.youtube.com/watch?v=JA96Fba-WHk

Cerella, J. (1980). A análise de imagens do pombo. Pattern Recognition, 12, 1-6.

Thorndike, E. L. (1898). Inteligência animal: Um estudo experimental dos processos associativos em animais. Washington, DC: American Psychological Association.

Image Attributions

Figure 8.6: Adaptado de Kassin (2003).