Objetivos de aprendizaje

- Explicar los principios del condicionamiento operante.

- Explicar cómo se puede modelar el aprendizaje mediante el uso de esquemas de refuerzo y reforzadores secundarios.

En el condicionamiento clásico el organismo aprende a asociar nuevos estímulos con respuestas biológicas naturales como la salivación o el miedo. El organismo no aprende algo nuevo, sino que comienza a realizar un comportamiento existente en presencia de una nueva señal. El condicionamiento operante, en cambio, es un aprendizaje que se produce en función de las consecuencias del comportamiento y puede implicar el aprendizaje de nuevas acciones. El condicionamiento operante se produce cuando un perro se da la vuelta cuando se le ordena porque se le ha elogiado por hacerlo en el pasado, cuando un matón de la escuela amenaza a sus compañeros porque hacerlo le permite salirse con la suya y cuando una niña saca buenas notas porque sus padres la amenazan con castigarla si no lo hace. En el condicionamiento operante el organismo aprende de las consecuencias de sus propias acciones.

Cómo influyen el refuerzo y el castigo en la conducta: Las investigaciones de Thorndike y Skinner

El psicólogo Edward L. Thorndike (1874-1949) fue el primer científico que estudió sistemáticamente el condicionamiento operante. En su investigación, Thorndike (1898) observó a gatos que habían sido colocados en una «caja rompecabezas» de la que intentaban escapar («Videoclip: La caja rompecabezas de Thorndike»). Al principio, los gatos arañaban, mordían y golpeaban al azar, sin saber cómo salir. Pero finalmente, y de forma accidental, pulsaron la palanca que abría la puerta y salieron hacia su premio, un trozo de pescado. La siguiente vez que el gato se vio constreñido dentro de la caja, intentó menos de las respuestas ineficaces antes de llevar a cabo la huida con éxito, y después de varios ensayos el gato aprendió a dar casi inmediatamente la respuesta correcta.

La observación de estos cambios en el comportamiento de los gatos llevó a Thorndike a desarrollar su ley del efecto, el principio de que las respuestas que crean un resultado típicamente agradable en una situación particular tienen más probabilidades de volver a ocurrir en una situación similar, mientras que las respuestas que producen un resultado típicamente desagradable tienen menos probabilidades de volver a ocurrir en la situación (Thorndike, 1911). La esencia de la ley del efecto es que las respuestas exitosas, por ser placenteras, están «grabadas» por la experiencia y, por tanto, ocurren con más frecuencia. Las respuestas infructuosas, que producen experiencias desagradables, se «sellan» y, en consecuencia, se producen con menos frecuencia.

Cuando Thorndike colocó a sus gatos en una caja de rompecabezas, descubrió que aprendían a realizar la conducta de escape importante más rápidamente después de cada ensayo. Thorndike describió el aprendizaje que sigue al refuerzo en términos de la ley del efecto.

Ver: «La caja de rompecabezas de Thorndike» : http://www.youtube.com/watch?v=BDujDOLre-8

Ver: «La caja de rompecabezas de Thorndike» : http://www.youtube.com/watch?v=BDujDOLre-8

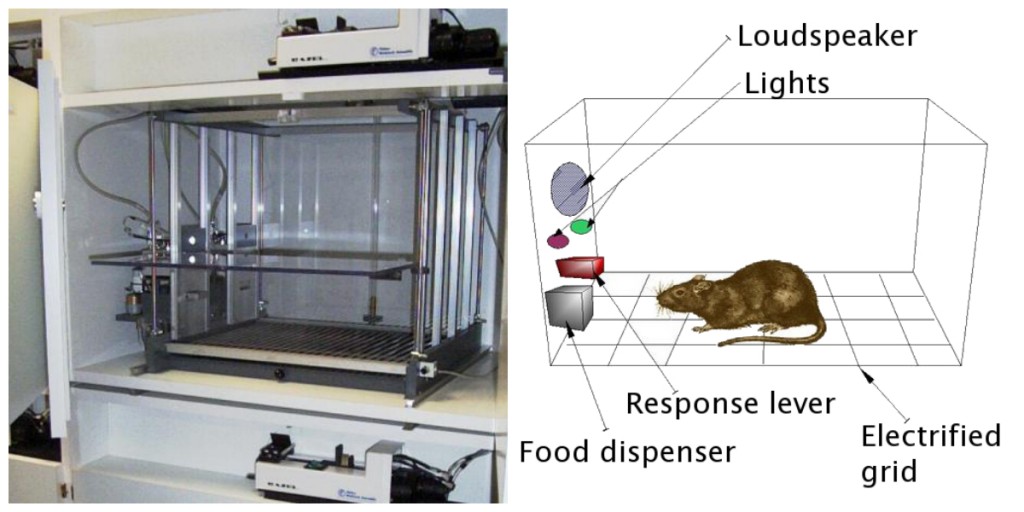

El influyente psicólogo conductista B. F. Skinner (1904-1990) amplió las ideas de Thorndike para desarrollar un conjunto más completo de principios para explicar el condicionamiento operante. Skinner creó entornos especialmente diseñados, conocidos como cámaras operantes (normalmente llamadas cajas de Skinner), para estudiar sistemáticamente el aprendizaje. Una caja de Skinner (cámara operante) es una estructura lo suficientemente grande como para que quepa un roedor o un pájaro y que contiene una barra o llave que el organismo puede presionar o picotear para liberar comida o agua. También contiene un dispositivo para registrar las respuestas del animal (Figura 8.5).

El más básico de los experimentos de Skinner era bastante similar a las investigaciones de Thorndike con gatos. Una rata colocada en la cámara reaccionaba como cabía esperar, correteando por la caja y oliendo y arañando el suelo y las paredes. Al final, la rata se topó con una palanca, que pulsó para liberar bolitas de comida. La siguiente vez, la rata tardó un poco menos en pulsar la palanca, y en sucesivas pruebas, el tiempo que tardaba en pulsar la palanca era cada vez más corto. Pronto la rata presionaba la palanca tan rápido como podía comer la comida que aparecía. Tal y como predecía la ley del efecto, la rata había aprendido a repetir la acción que provocaba la comida y a cesar las acciones que no lo hacían.

Skinner estudió, en detalle, cómo los animales cambiaban su comportamiento a través del refuerzo y el castigo, y desarrolló términos que explicaban los procesos de aprendizaje operante (Tabla 8.1, «Cómo influyen el refuerzo positivo y el negativo y el castigo en el comportamiento»). Skinner utilizó el término reforzador para referirse a cualquier acontecimiento que refuerza o aumenta la probabilidad de una conducta, y el término castigador para referirse a cualquier acontecimiento que debilita o disminuye la probabilidad de una conducta. Y utilizó los términos positivo y negativo para referirse a la presentación o eliminación de un refuerzo, respectivamente. Así, el refuerzo positivo refuerza una respuesta presentando algo agradable después de la respuesta, y el refuerzo negativo refuerza una respuesta reduciendo o eliminando algo desagradable. Por ejemplo, elogiar a un niño por haber hecho los deberes representa un refuerzo positivo, mientras que tomar una aspirina para reducir el dolor de cabeza representa un refuerzo negativo. En ambos casos, el refuerzo hace más probable que el comportamiento se repita en el futuro.

| Descripción | Resultado | Ejemplo | |

|---|---|---|---|

| Refuerzo positivo | Añadir o aumentar un estímulo agradable | Se refuerza la conducta | Dar un premio a un estudiante después de que obtenga un sobresaliente en un examen | Refuerzo negativo | Reducir o eliminar un estímulo desagradable | Se refuerza la conducta | Tomar analgésicos que eliminan el dolor aumenta la probabilidad de que vuelva a tomar analgésicos |

| Castigo positivo | Presentar o añadir un estímulo desagradable | Se debilita el comportamiento | Dar a un alumno deberes extra después de que se porte mal en clase |

| Castigo negativo | Reducir o eliminar un estímulo agradable | Se debilita el comportamiento | Retirar ordenador de un adolescente después de que falte al toque de queda |

El refuerzo, ya sea positivo o negativo, funciona aumentando la probabilidad de un comportamiento. El castigo, por otro lado, se refiere a cualquier evento que debilita o reduce la probabilidad de un comportamiento. El castigo positivo debilita una respuesta presentando algo desagradable después de la respuesta, mientras que el castigo negativo debilita una respuesta reduciendo o eliminando algo agradable. Un niño que está castigado después de pelearse con un hermano (castigo positivo) o que pierde la oportunidad de ir al recreo después de obtener una mala nota (castigo negativo) tiene menos probabilidades de repetir estas conductas.

Aunque la distinción entre refuerzo (que aumenta la conducta) y castigo (que la disminuye) suele estar clara, en algunos casos es difícil determinar si un reforzador es positivo o negativo. En un día caluroso, una brisa fresca puede considerarse un refuerzo positivo (porque aporta aire fresco) o un refuerzo negativo (porque elimina el aire caliente). En otros casos, el refuerzo puede ser tanto positivo como negativo. Uno puede fumar un cigarrillo tanto porque le produce placer (refuerzo positivo) como porque elimina el ansia de nicotina (refuerzo negativo).

También es importante señalar que el refuerzo y el castigo no son simplemente opuestos. El uso del refuerzo positivo para cambiar el comportamiento es casi siempre más eficaz que el uso del castigo. Esto se debe a que el refuerzo positivo hace que la persona o el animal se sienta mejor, ayudando a crear una relación positiva con la persona que proporciona el refuerzo. Los tipos de refuerzo positivo que resultan eficaces en la vida cotidiana son los elogios verbales o la aprobación, la concesión de estatus o prestigio y el pago económico directo. El castigo, en cambio, es más probable que sólo genere cambios temporales en el comportamiento porque se basa en la coerción y suele crear una relación negativa y adversa con la persona que proporciona el refuerzo. Cuando la persona que proporciona el castigo abandona la situación, es probable que la conducta no deseada vuelva a aparecer.

Creación de conductas complejas a través del condicionamiento operante

Quizás recuerde haber visto una película o haber asistido a un espectáculo en el que un animal -quizás un perro, un caballo o un delfín- hacía cosas increíbles. El entrenador daba una orden y el delfín nadaba hasta el fondo de la piscina, recogía un anillo en su nariz, salía del agua a través de un aro en el aire, volvía a sumergirse en el fondo de la piscina, recogía otro anillo y luego llevaba ambos anillos hasta el entrenador en el borde de la piscina. El animal fue entrenado para hacer el truco, y se utilizaron los principios del condicionamiento operante para entrenarlo. Pero estos comportamientos complejos están muy lejos de las simples relaciones estímulo-respuesta que hemos considerado hasta ahora. ¿Cómo puede utilizarse el refuerzo para crear conductas complejas como éstas?

Una forma de ampliar el uso del aprendizaje operante es modificar el horario en el que se aplica el refuerzo. Hasta ahora sólo hemos hablado de un programa de refuerzo continuo, en el que la respuesta deseada se refuerza cada vez que se produce; cada vez que el perro se da la vuelta, por ejemplo, recibe una galleta. El refuerzo continuo da lugar a un aprendizaje relativamente rápido, pero también a una rápida extinción de la conducta deseada una vez que desaparece el reforzador. El problema es que, como el organismo está acostumbrado a recibir el refuerzo después de cada conducta, el que responde puede rendirse rápidamente cuando no aparece.

La mayoría de los reforzadores del mundo real no son continuos; se producen en un programa de refuerzo parcial (o intermitente), un programa en el que las respuestas se refuerzan a veces y otras no. En comparación con el refuerzo continuo, los programas de refuerzo parcial conducen a un aprendizaje inicial más lento, pero también conducen a una mayor resistencia a la extinción. Como el refuerzo no aparece después de cada conducta, el alumno tarda más tiempo en darse cuenta de que la recompensa ya no llega, por lo que la extinción es más lenta. Los cuatro tipos de esquemas de refuerzo parcial se resumen en la Tabla 8.2, «Esquemas de refuerzo»

| Explicación | Ejemplo real-ejemplo del mundo | |

|---|---|---|

| Razón fija | La conducta se refuerza tras un número específico de respuestas. | Trabajadores de una fábrica a los que se les paga según el número de productos que producen | Razón variable | El comportamiento se refuerza tras un número medio, pero impredecible, de respuestas. | Pagos de máquinas tragaperras y otros juegos de azar | Intervalo fijo | El comportamiento se refuerza por la primera respuesta después de que haya pasado una cantidad de tiempo específica. | Personas que ganan un salario mensual | Intervalo variable | Se refuerza el comportamiento para la primera respuesta después de que haya pasado una cantidad de tiempo media, pero impredecible. | Persona que revisa el correo electrónico en busca de mensajes |

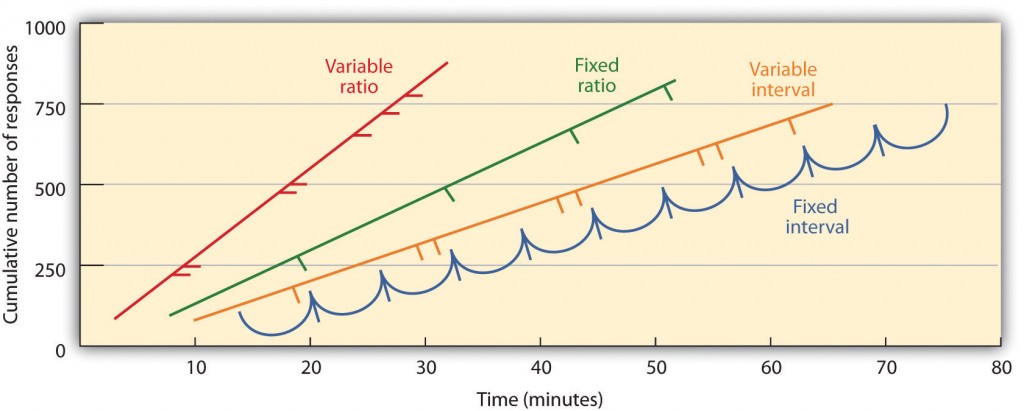

Los esquemas de refuerzo parcial están determinados por si el refuerzo se presenta en función del tiempo que transcurre entre los refuerzos (intervalo) o en función del número de respuestas que el organismo realiza (ratio), y si el refuerzo se produce en un horario regular (fijo) o imprevisible (variable). En un programa de intervalo fijo, el refuerzo se produce para la primera respuesta realizada después de que haya transcurrido un tiempo determinado. Por ejemplo, en un programa de intervalo fijo de un minuto, el animal recibe un refuerzo cada minuto, suponiendo que realice la conducta al menos una vez durante ese minuto. Como se puede ver en la Figura 8.6, «Ejemplos de patrones de respuesta de animales entrenados con diferentes programas de refuerzo parcial», los animales con programas de intervalo fijo tienden a ralentizar su respuesta inmediatamente después del refuerzo, pero vuelven a aumentar la conducta cuando se acerca el momento del siguiente refuerzo. (La mayoría de los estudiantes estudian para los exámenes de la misma manera.) En un programa de intervalo variable, los reforzadores aparecen en un programa de intervalo, pero el momento varía en torno al intervalo medio, haciendo que la aparición real del reforzador sea impredecible. Un ejemplo podría ser revisar el correo electrónico: se le refuerza recibiendo mensajes que llegan, por término medio, digamos, cada 30 minutos, pero el refuerzo se produce sólo en momentos aleatorios. Los programas de refuerzo a intervalos tienden a producir tasas de respuesta lentas y constantes.

En un programa de proporción fija, un comportamiento se refuerza después de un número específico de respuestas. Por ejemplo, el comportamiento de una rata puede ser reforzado después de que haya pulsado una tecla 20 veces, o un vendedor puede recibir una bonificación después de que haya vendido 10 productos. Como se puede ver en la figura 8.6, «Ejemplos de patrones de respuesta de animales entrenados con diferentes esquemas de refuerzo parcial», una vez que el organismo ha aprendido a actuar de acuerdo con el esquema de proporción fija, sólo hará una breve pausa cuando se produzca el refuerzo antes de volver a un alto nivel de respuesta. Un programa de proporción variable proporciona refuerzos después de un número específico pero medio de respuestas. Ganar dinero en las máquinas tragaperras o en un billete de lotería es un ejemplo de refuerzo que se produce en un programa de proporción variable. Por ejemplo, una máquina tragaperras (véase la Figura 8.7, «Máquina tragaperras») puede estar programada para proporcionar una ganancia cada 20 veces que el usuario tira de la manivela, por término medio. Los programas de relación tienden a producir altas tasas de respuesta porque el refuerzo aumenta a medida que el número de respuestas aumenta.

Las conductas complejas también se crean a través del moldeado, el proceso de guiar la conducta de un organismo hacia el resultado deseado mediante el uso de aproximaciones sucesivas a una conducta final deseada. Skinner utilizó ampliamente este procedimiento en sus cajas. Por ejemplo, podía entrenar a una rata para que presionara una barra dos veces para recibir comida, proporcionándole primero comida cuando el animal se acercaba a la barra. Una vez aprendida esa conducta, Skinner empezaba a proporcionar comida sólo cuando la rata tocaba la barra. El refuerzo se limitaba a cuando la rata presionaba la barra, a cuando presionaba la barra y la tocaba por segunda vez y, finalmente, a cuando presionaba la barra dos veces. Aunque puede llevar mucho tiempo, de este modo el condicionamiento operante puede crear cadenas de comportamientos que se refuerzan sólo cuando se completan.

Reforzar a los animales si discriminan correctamente entre estímulos similares permite a los científicos probar la capacidad de aprendizaje de los animales, y las discriminaciones que pueden hacer son a veces notables. Se ha entrenado a las palomas para que distingan entre las imágenes de Charlie Brown y los demás personajes de Peanuts (Cerella, 1980), y entre diferentes estilos de música y arte (Porter & Neuringer, 1984; Watanabe, Sakamoto & Wakita, 1995).

Las conductas también pueden entrenarse mediante el uso de reforzadores secundarios. Mientras que un reforzador primario incluye estímulos que son naturalmente preferidos o disfrutados por el organismo, como la comida, el agua y el alivio del dolor, un reforzador secundario (a veces llamado reforzador condicionado) es un evento neutral que se ha asociado con un reforzador primario a través del condicionamiento clásico. Un ejemplo de reforzador secundario sería el silbido que da un entrenador de animales, que se ha asociado con el tiempo al reforzador primario, la comida. Un ejemplo de reforzador secundario cotidiano es el dinero. Nos gusta tener dinero, no tanto por el estímulo en sí, sino por los reforzadores primarios (las cosas que el dinero puede comprar) con los que está asociado.

Los puntos clave

- Edward Thorndike desarrolló la ley del efecto: el principio de que las respuestas que crean un resultado típicamente agradable en una situación particular tienen más probabilidades de volver a ocurrir en una situación similar, mientras que las respuestas que producen un resultado típicamente desagradable tienen menos probabilidades de volver a ocurrir en la situación.

- B. F. Skinner amplió las ideas de Thorndike para desarrollar un conjunto de principios para explicar el condicionamiento operante.

- El refuerzo positivo refuerza una respuesta presentando algo que es típicamente agradable después de la respuesta, mientras que el refuerzo negativo refuerza una respuesta reduciendo o eliminando algo que es típicamente desagradable.

- El castigo positivo debilita una respuesta presentando algo típicamente desagradable después de la respuesta, mientras que el castigo negativo debilita una respuesta reduciendo o eliminando algo que es típicamente agradable.

- El refuerzo puede ser parcial o continuo. Los programas de refuerzo parcial se determinan en función de si el refuerzo se presenta sobre la base del tiempo que transcurre entre los refuerzos (intervalo) o sobre la base del número de respuestas que el organismo realiza (proporción), y de si el refuerzo se produce en un programa regular (fijo) o impredecible (variable).

- Las conductas complejas pueden crearse a través de la conformación, el proceso de guiar la conducta de un organismo hacia el resultado deseado mediante el uso de aproximaciones sucesivas a una conducta final deseada.

Ejercicios y pensamiento crítico

- Da un ejemplo de la vida cotidiana de cada uno de los siguientes: refuerzo positivo, refuerzo negativo, castigo positivo, castigo negativo.

- Considera las técnicas de refuerzo que podrías utilizar para entrenar a un perro para que atrape y recupere un frisbee que le lances.

- Mira los siguientes dos vídeos de programas de televisión actuales. ¿Puede determinar qué procedimientos de aprendizaje se están demostrando?

- The Office: http://www.break.com/usercontent/2009/11/the-office-altoid- experimento-1499823

- The Big Bang Theory : http://www.youtube.com/watch?v=JA96Fba-WHk

Cerella, J. (1980). El análisis de imágenes por parte de la paloma. Pattern Recognition, 12, 1-6.

Thorndike, E. L. (1898). La inteligencia animal: Un estudio experimental de los procesos asociativos en los animales. Washington, DC: American Psychological Association.

Atribuciones de imágenes

Figura 8.6: Adaptada de Kassin (2003).